Il 2012 non sarà ricordato solo come uno degli anni più duri della crisi, ma anche come il momento di ripartenza per moltissime aziende secondo inediti paradigmi operativi. Alla base di questo cambiamento ci sono le nuove forme di esternalizzazione dell’Ict e il ruolo centrale dell’informazione, del dato puro come capitale da valorizzare e spendere in tempo reale per ogni azienda. Questo è l’aspetto in cui diventa fondamentale integrare la Business intelligence in profondità nei processi decisionali, mentre i responsabili dell’Ict hanno il dovere di verificare con rigore l’efficacia di questi strumenti, che in qualche caso forse peccano di gioventù, ma se ben tarati possono davvero fare la differenza. Nel nostro Focus abbiamo raccolto una panoramica di quanto offre il mercato e un’analisi dello scenario in cui questi strumenti diventano necessari per aziende di ogni livello, nella certezza che nei prossimi anni nessun player competitivo, grande o piccolo, potrà ignorarne le potenzialità.

Cos’è la Business intelligence

Fino a poco tempo fa il termine Bi era associato a concetti di interesse esclusivamente accademico come algoritmi di autoapprendimento e tecniche di analisi del linguaggio naturale. Oggi gli strumenti di Bi dovrebbero costituire l’insieme delle tecniche finalizzate a trasformare in conoscenza e informazioni utili l’universo caotico dei dati aziendali, che assume via via proporzioni sempre più mastodontiche con l’integrazione di informazioni periferiche all’azienda, come quelle provenienti da social network. Il condizionale è d’obbligo visto che il termine abbraccia molte applicazioni diverse, ciascuna con le sue difficoltà di implementazione, i suoi costi di realizzazione e le sue esigenze di customizzazione.

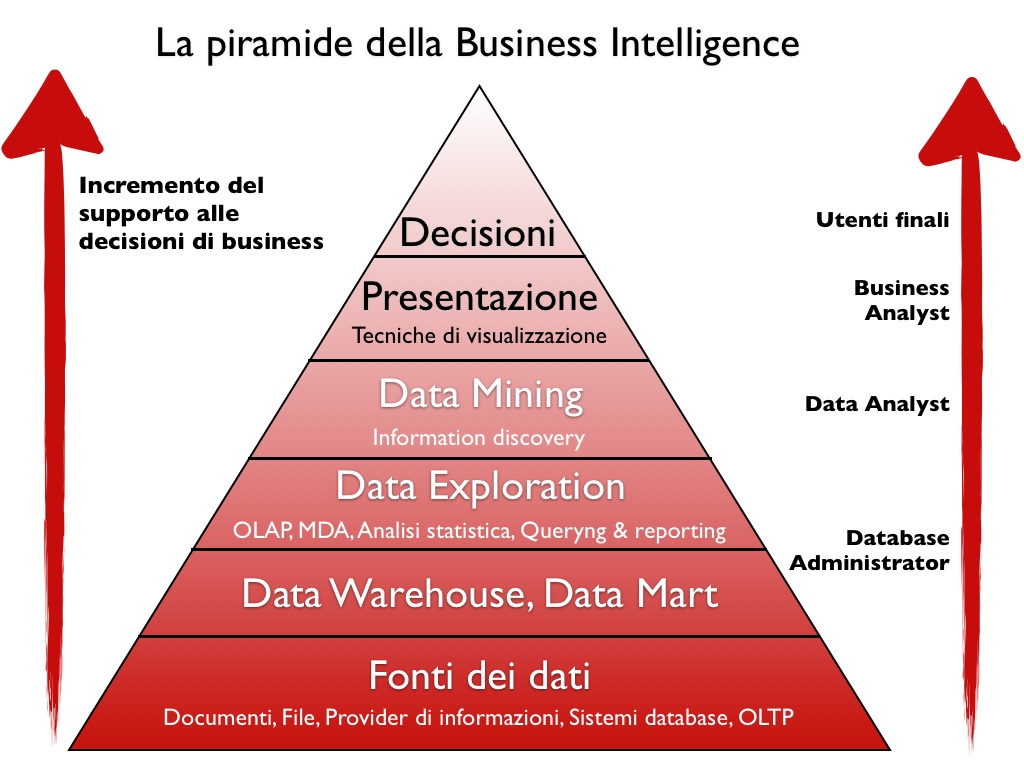

Quello della Business intelligence è quindi un sistema che coinvolge ogni livello dell’infrastruttura tecnologica dell’azienda, poiché tutte le informazioni devono essere distillate per rendere più efficienti e precisi i processi decisionali.

La struttura della Bi può quindi essere concepita come una piramide, alla base della quale c’è il processo di raccolta dei dati con le infrastrutture a esso collegate. Salendo ai piani superiori si incontrano gli strumenti analitici basati sulla statistica e le attività di data mining, che usano anche reti neurali per identificare pattern anomali e quindi interessanti, nel mare dei dati a disposizione.

Ovvio che le implementazioni più raffinate di un processo di Business intelligence richiedono grande potenza di calcolo e sono costose, ma possono ricavare previsioni preziose e attendibili anche a medio termine dell’andamento del business. Una volta implementata in azienda una struttura di Bi, bisogna poi saper usare gli strumenti a disposizione e per comprendere appieno tecniche e applicazioni sono necessarie competenze trasversali. Bisogna prima di tutto sapersi approcciare ai dati da una prospettiva di business, il che può non essere facile per chi parte da una formazione troppo tecnica. Inoltre è necessario avere le idee chiare sulle domande a cui l’analisi dovrebbe dare una risposta e sulle azioni di business che si è disposti a intraprendere una volta ottenuti i risultati. Se correttamente sfruttata, la Bi permette di conoscere veramente interessi e aspettative dei propri clienti attuali e potenziali, in un modo via via sempre più preciso offrendo ai decisori strumenti di visualizzazione delle analisi molto evoluti e disponibili anche per dispositivi mobili.

Quanto devono essere precisi i dati

Uno dei più grossi problemi che deve affrontare un sistema di Business intelligence è quello della qualità dei dati di partenza, che possono essere largamente incompleti, inaffidabili o corrotti. Il sistema implementato dovrà essere tanto più complesso e sofisticato quanto meno puliti saranno i dati a disposizione, ma nessun algoritmo è in grado di offrire previsioni attendibili in presenza di informazioni gravemente inadeguate.

Fortunatamente non tutti i processi di analisi richiedono dati del tutto accurati, e anche il settore in cui opera l’azienda e l’impiego che si vuole fare dei risultati possono rendere più o meno necessario un alto livello di verifica.

Quel che è certo è che non potrebbe esserci un momento più propizio per la Business intelligence, le sue applicazioni e le figure professionali di analisti e tecnici a essa collegate.

Fornita on premise o come servizio esterno, è ormai declinabile in implementazioni adeguate a qualsiasi dimensione aziendale e in pochi anni nessuna azienda competitiva potrà farne a meno, non necessariamente a fronte di investimenti troppo onerosi.

In-memory analytics

Oltre a visual analytics e mobile, la tendenza tecnologica che più influenza lo sviluppo della BI è l’approccio in-memory, che assicura prestazioni prima impensabili. Identificata da Gartner nella top ten delle tecnologie da considerare strategiche nel 2012, l’in-memory computing consiste nello sfruttare le prestazioni della Ram per ridurre i tempi delle analisi sui dati. Memorizzare in modo temporaneo i dati su cui si devono effettuare query complesse nella memoria volatile, invece di accedervi attraverso tradizionali sistemi di storage, siano essi pure veloci ssd, consente infatti attività praticamente in tempo reale ottenendo quell’immediatezza di risposta che in alcuni settori è la chiave del successo delle attività di business.

Si tratta di un’innovazione figlia del calo nel prezzo della Ram e della diffusione di sistemi operativi a 64 bit, in grado di indirizzare ben più di 4GB senza applicare logiche di segmentazione. Con i sistemi attuali in grado di indirizzare fino a un terabyte di Ram è teoricamente possibile, ancorché comunque costoso, caricare in Ram un intero data warehouse o data mart.

Operando con una cache così ampia, questo approccio rende inoltre superfluo l’uso di tecniche di indicizzazione dei dati e l’impiego di pre-aggregati OLAP, riducendo la complessità delle implementazioni di applicazioni analitiche.

Sull’approccio in-memory tutti i grandi vendor che si occupano di BI, a partire da Sas, Sap, Ibm e QlikView, hanno qualcosa di interessante da offrire, ma al momento è difficile immaginare che questa evoluzione possa sostituire tecniche più tradizionali.

Nel suo blog sul sito di Ibm Adam Ronthal Sr. Technical Marketing Analyst di Netezza, si interroga su questo approccio in rapporto alla velocità di crescita dei dati. Se un’attività “all in-memory” può garantire prestazioni da 10 a 1000 volte superiori, le soluzioni più tradizionali riescono a governare enormi moli di dati senza raggiungere costi proibitivi. E in un’epoca in cui gli utenti generano 2,5 exabyte di dati al giorno, confrontarsi con simili montagne di informazioni è una questione sempre più diffusa.

Ricorda infatti Ronthal che nel valutare in sistema in-memory bisogna considerare che dietro la Ram devono esserci anche dischi fisici per mantenere la persistenza dei dati, tipicamente 5 volte più capienti. Per cui ci vuole 1 petabyte di storage per gestire 200 TB di dati compressi in Ram.